Un comando y aplicaciones gráficas para descargar todo el contenido de un sitio web

Escrito por

el .

gnu-linux

planeta-codigo

Enlace permanente

Comentarios

La necesidad puede ser hacer una copia de seguridad periódicas para conservar el historial del sitio web, descargar el contenido para procesarlo de alguna forma, para consultarlo sin conexión a internet u offline si nuestra conexión es lenta o inestable o el servidor está caído, migrar un sitio web de un servidor web a otro o descargar los archivos de vídeo, audio, imágenes o multimedia.

Los navegadores web con el botón derecho del ratón ofrecen la posibilidad de descargar y guardar en el sistema de archivos la página que se está visualizando, está es la opción más simple ya que no se necesitan herramientas adicionales si solo se quiere guardar una página de las muchas de un sitio web. Su desventaja es que no sirve para guardar un sitio web completo por requerir hacer la operación manualmente por cada página, de forma que para realizar la operación de forma másiva y automatizada para el sitio web completo hay que utilizar alguna herramienta especializada.

Contenido del artículo

Cómo descargar un sitio web desde la línea de comandos con wget

La herramienta de línea de comandos wget permite descargar un sitio web completo con un comando ejecutado desde la terminal incluyendo los archivos HTML y de recursos como imágenes, vídeos, contenido multimedia como audio o música, de estilos CSS o archivos JavaScript. El contenido que descarga wget es el referenciado a través de los enlaces presentes en el propio contenido, wget explora los archivos HTML en busca de enlaces a recursos u otras páginas HTML y de forma recursiva descarga el contenido completo al sistema de archivos local. Está disponible para los sistemas operativos Windows, GNU/Linux y macOS y es una herramienta de software libre y gratuita.

Basta indicar el o los dominios del sitio web de los que se quiere descargar el contenido y la URL de rastreo de inicio u otras URLs adicionales que se desean descargar. Este comando con las opciones indicadas solo descarga los enlaces del sitio web puesto como argumento, los enlaces a sitios web externos no indicados expresamente en la opción –domain son ignorados. El comando wget soporta numerosas opciones para personalizar la descarga explicadas en su página de manual.

|

|

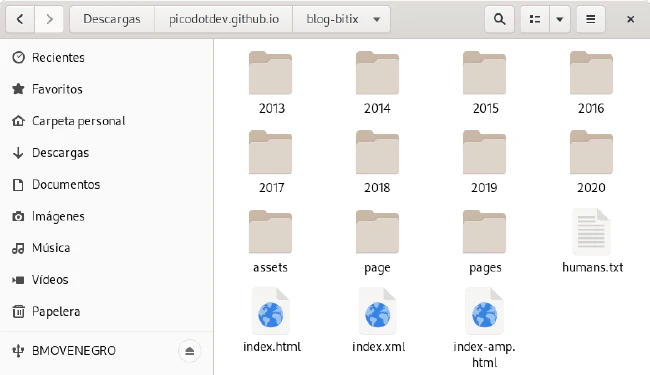

Terminado el proceso de descarga el contenido del sitio web se guarda en el sistema de archivos conservando la jerarquía de carpetas de las URLs de los recursos.

Descargar un sitio web no es la única funcionalidad que ofrece wget, otra necesidad habitual es buscar los enlaces rotos de una página web que con el paso del tiempo se van generando ya sea porque los sitios web externos desaparecen o por errores en la edición y enlazado interno. Conocer los enlaces rotos permite arreglarlos para ofrecer mejor experiencia de usuario al visitante y para mejorar el SEO en el posicionamiento en los buscadores.

Cómo descargar un sitio web con programas de interfaz gráfica o páginas web

Hay algunas herramientas con interfaz gráfica como HTTrack o Cyotek WebCopy que realizan la misma tarea que wget de forma más intuitiva. Aún así el comando de wget es una forma sencilla y rápida de realizar la descarga de un sitio web completo.

También hay algunas herramientas o páginas web online que realizan la descarga de sitios web como Website Downloader o Archivarix sin necesidad de instalar ningún programa en el ordenador aunque tienen unos límites muy reducidos que sobrepasados no son gratuitas y hay que pagar por utilizarlas.